A Inteligência Artificial (IA) não deveria ser novidade para ninguém. Desde os trabalhos pioneiros de Alan Turing na primeira metade do século passado, cientistas da computação tem se dedicado a esse assunto por décadas. Eu mesmo tive uma disciplina de IA na minha graduação em Ciências da Computação, lá no meados da década de 90.

Mas o surgimento do ChatGPT no final de 2022 trouxe um novo holofote para esse assunto e, assim como diversas ferramentas e apps que surgiram recentemente, tornou a IA acessível para a população em geral. E, vamos ser sinceros: o fenômeno foi tão marcante que o ChatGPT praticamente virou um sinônimo para IA.

A rápida popularização de algumas ferramentas de IA (do ChatGPT a ferramentas para criar imagens, como o Lensa e a Midjourney, além de muitos outros aplicativos) tem chamado muita atenção de todos e trouxe a Inteligência Artificial para o dia--a-dia das pessoas. E para o centro dos debates.

Existem milhares de ferramentas de IA, e as mais faladas atualmente são o ChatGPT (da OpenAI), Bing AI (Microsoft) e o Gemini Bard (Google). Mas tem ferramentas para todo tipo de uso, mais de 70 mil empresas no mercado de IA, e a cada dia surgem novas aplicações. As possibilidades tecnológicas e de uso da IA, em especial essas apresentadas pelo ChatGPT, ainda são embrionárias e muito ainda está por acontecer. Ainda vamos ver muita discussão sobre a tecnologia e sobre os aspectos éticos de seu uso.

Vivemos uma "bolha da IA"? Com certeza!

De qualquer forma, decidi criar esse post para registrar artigos, notícias relevantes e fatos que acho interessantes no uso e debate relacionado aos aspectos de segurança (riscos, uso malicioso, incidentes, etc).

Vale a pena destacar que já tivemos alguns incidentes de segurança relacionados ao uso do ChatGPT. Já tivemos o vazamento de dados cadastrais de usuários da ferramenta, além de um incidente icônico em Março de 2023, quando foi noticiado que funcionários da Samsung compartilhavam informações confidenciais ao usar o ChatGPT.

Segue, abaixo, minha humilde coletânea de artigos, relatórios, reportagens, links e memes sobre o assunto.

Aspectos gerais de segurança na IA

O desenvolvimento e o uso de ferramentas de inteligência artificial envolve diversos cuidados de segurança, e algumas iniciativas já estão discutindo isso.

Para começar a estudar esse assunto, vale a pena ver esse documento da CISA com a NCSC: Guidelines for Secure AI System Development (Diretrizes para o Desenvolvimento Seguro de Sistemas de IA), em inglês, lançado em 26/11/2023.

- Uma ótima visão geral e objetiva sobre o assunto: Como o ChatGPT vai mudar a cibersegurança (Kaspersky, 08/02/2023)

- AI Risk Management Framework (NIST) (26/01/2023)

- AI and cybersecurity: How to navigate the risks and opportunities (Fórum Econômico Mundial, 29/02/2024)

- Material da Cloud Security Alliance:

- Security Implications of ChatGPT (02/08/2023)

- The State of AI and Security Survey Report (02/04/2024)

- Material da OWASP:

- OWASP AI Security and Privacy Guide (em inglês) (OWASP)

- OWASP Top 10 for Large Language Model Applications (em inglês) (OWASP) (anúncio)

- LLM AI Cybersecurity & Governance Checklist (pdf) (em inglês)

- Gabriela Salles: Inteligência Artificial: Risco ou oportunidade? (Tecsec Podcast EP #444, 18/05/2023)

- Hackers acham difícil que a IA substitua a ‘criatividade’ humana (CISO Advisor, 16/07/2023)

- Pesquisadores encontram formas de burlar segurança do ChatGPT e outras IAs (TecMundo, 28/07/2023)

- Descoberta de falhas no ChatGPT revelam vulnerabilidades no campo da IA (Olhar Digital, 03/08/2023)

- IA dominou os debates nos maiores eventos de cibersegurança do mundo (Inovativos, 31/08/2023)

- ChatGPT at work: how chatbots help employees, but threaten business (em inglês) (Securelist, 13/10/2023)

- CISA and UK NCSC Unveil Joint Guidelines for Secure AI System Development (em inglês) (CISA, 26/11/2023)

- Story of the year: the impact of AI on cybersecurity (em inglês) (Kaspersky, 11/12/2023)

- Relatório do Fórum Econômico Mundial 2024:

- Infográfico interativo bem legal: Artificial Intelligence (em inglês)

- AI - artificial intelligence - at Davos 2024: What to know (em inglês) (14/01/2024)

- Cybersecurity is on the frontline of our AI future. Here's why (em inglês) (15/01/2024)

- From Sam Altman to António Guterres: Here's what 10 leaders said about AI at Davos 2024 (em inglês) (23/01/2024)

- Davos 2024: Here's the impact on-ground across AI, climate, growth and global security (em inglês) (25/01/2024)

- AI and emerging technology at Davos 2024: 5 surprising things to know (em inglês) (26/01/2024)

- AI and cybersecurity: How to navigate the risks and opportunities (em inglês) (29/02/2024)

- Fórum Econômico Mundial: Cibercrime e IA estão entre os riscos globais dos próximos anos (Security Report, 10/01/2024)

- Inteligência Artificial é o maior perigo do mundo nos próximos dois anos (Convergência Digital, 15/01/2024)

- CISA Joins ACSC-led Guidance on How to Use AI Systems Securely (em inglês) (CISA, 23/01/2024)

- NIST Risk Management Framework Aims to Improve Trustworthiness of Artificial Intelligence (em inglês) (NIST, 26/01/2024)

- Joint Guidance on Deploying AI Systems Securely (PDF) (em inglês) (CISA, 15/04/2024)

- AI Models in Cybersecurity: From Misuse to Abuse (em inglês) (Security Week, 16/10/2024)

- OWASP Top 10 para LLMs: Guia Estratégico para Defesa na Era da IA (SegInfo, 22/05/2025)

- New Best Practices Guide for Securing AI Data Released (em inglês) (CISA, 22/05/2025)

- AI Safety Index (em inglês) (Future of Life, 17/07/2025)

- Perplexity lança BrowseSafe para proteger navegadores de IA (IA Express, 05/12/2025)

O bom uso da IA para aprimorar a postura e as ferramentas de segurança

Há muito já se fala utilizar a IA em cibersegurança, principalmente em ferramentas para melhorar sua performance, como nos casos de ferramentas de detecção de ataque, antivírus e ferramentas para detecção de fraudes. Com o novo boom da IA, sua adoção tende a aumentar significativamente (fique atento, pois dependendo da empresa isso pode ser verdade ou apenas um discurso marketeiro).

Já há especulações e iniciativas para usar as tecnologias de IA de forma a facilitar ou agilizar o trabalho dos times de segurança. Há grande expectativa de que essa tecnologia ajude a automatizar ainda mais processos repetitivos e atividades que possam ser automatizadas. Há também quem acredite que a IA pode melhorar a produção de análises e relatórios.

Vejamos alguns casos e notícias sobre isso...

- Cybersecurity takes a leap forward with AI tools and techniques (em inglês) (Help Net Security, 20/02/2023)

- Most security pros turn to unauthorized AI tools at work (em inglês) (Help Net Security, 17/03/2023)

- How ChatGPT is changing the cybersecurity game (em inglês) (Help Net Security, 28/03/2023)

- Inteligência Artificial ganha protagonismo na RSA Conference (Security Report, 26/04/2023)

- Prevenção de ameaças orientada por IA é uma tendência que evoluiu rapidamente em 2023, diz CISO da Check Point (TI Inside, 16/06/2023)

- How AI-Augmented Threat Intelligence Solves Security Shortfalls (em inglês) (Dark Reading, 17/07/2023)

- Especialista do IEEE explica por que IA será fundamental à cibersegurança (TI Inside, 01/08/2023)

- Palestra na Black Hat 2023: What Does an LLM-Powered Threat Intelligence Program Look Like? (em inglês) (Black Hat USA, 10/08/2023)

- Why I Chose Google Bard to Help Write Security Policies (em inglês) (Dark Reading, 19/12/2023)

- PornHub usa chatbot para intervir em mais de 4 milhões de buscas por abuso sexual infantil (Tecmundo, 29/02/2024)

- ChatGPT vs. Gemini: Which Is Better for 10 Common Infosec Tasks? (em inglês) (Dark Reading, 15/03/2024)

- Taiwan using AI to fight disinformation campaigns, former minister says (em inglês) (The Record, 14/02/2025)

- Análise de Malware:

- GPT VS Malware Analysis: Challenges and mitigations (em inglês) (Checkpoint Research, 15/11/2023)

- Análise de código e descoberta de vulnerabilidades:

- GreyNoise Intelligence Discovers Zero-Day Vulnerabilities in Live Streaming Cameras with the Help of AI (em inglês) (GreyNoise, 31/10/2024)

- Google uses large language model to discover real-world vulnerability (em inglês) (Bleeping Computer, 03/11/2024)

- Using LLMs to Analyze Windows Binaries (em inglês) (Google, 04/10/2024)

- Linux Zero-Day Vulnerability Discovered Using Frontier AI (em inglês) (BankInfo Security, 30/05/2025)

- Combate a fraudes:

- What does ChatGPT know about phishing? (em inglês) (Securelist, 01/05/2023)

- O ChatGPT pode detectar golpes online? Nós testamos! (Kaspersky, 19/05/2023)

- As principais aplicações de IA no combate às fraudes financeiras (TI Inside, 01/08/2023)

- 'Vovó boa de papo' criada por IA é arma para enganar golpistas por telefone (UOL, 28/11/2024)

- Using AI to outsmart AI-driven phishing scams (em inglês) (Help Net Security, 30/05/2025)

- Novas ferramentas e projetos de segurança com IA:

- OPWNAI: AI that can save the day or hack it anyway (em inglês) (Checkpoint Research, 19/12/2022)

- I, Chatbot (em inglês) (Recorded Future, 26/01/2023)

- Europol details ChatGPT’s potential for criminal abuse (em inglês) (Help Net Security, 28/03/2023) (documento original)

- Contextualizing Deepfake Threats to Organizations (em inglês) (CISA, 12/09/2023)

- Stack Overflow bans ChatGPT as 'substantially harmful' for coding issues (em inglês) (The Register, 21/12/2022)

- Study finds AI assistants help developers produce code that's more likely to be buggy (em inglês) (The Register, 21/12/2022)

- OPWNAI: Cybercriminals starting to use ChatGPT (em inglês) (Checkpoint Research, 06/01/2023)

- ChatGPT: 6 formas em que a ferramenta pode ser utilizada por cibercriminosos (CryptoID, 10/02/2023)

- ChatGPT é usado para criar ameaças cada vez mais convincentes (Canaltech, 02/03/2025)

- Workers are secretly using ChatGPT, AI and it will pose big risks for tech leaders (em inglês) (CNBC, 30/04/2023)

- Inteligência artificial consegue descobrir senhas em menos de 1 minuto; saiba se proteger (Olhar Digital, 07/04/2023)

- Meta adverte sobre ameaça de malware em IA generativa (TI Inside, 04/05/2023)

- Os 4 usos “favoritos” da Inteligência Artificial pelos cibercriminosos (Security Report, 21/07/2023)

- Líderes de segurança dizem que IA tem sido usada em ataques (CISO Advisor, 21/08/2023)

- Inteligência Artificial tem sido uma das ferramentas mais visadas por cibercriminosos (Security Report, 27/09/2023)

- Protecting against FraudGPT, ChatGPT’s evil twin (Help Net Security, 02/10/2023)

- ChatGPT Cybercrime Discussions Spike to Nearly 3K Posts on Dark Web (em inglês) (Dark Reading, 24/01/2024)

- AI-Powered Attacks Flood Retail Websites (em inglês) (Infosecurity Magazine, 22/10/2024)

- OpenAI Blocks 20 Global Malicious Campaigns Using AI for Cybercrime and Disinformation (em inglês) (Bleeping Computer, 10/10/2024)

- Hackers Use Image-Based Malware and GenAI to Evade Email Security (em inglês) (Infosecurity Magazine, 16/01/2025)

- IA já é usada para ajudar a assassinar pessoas, diz governo dos EUA (TecMundo, 20/01/2025)

- Como hackers de China, Irã e Rússia usam a IA da Google em ciberataques? (TecMundo, 30/01/2025)

- Hackers da China e Rússia usam Gemini para atacar o mundo, diz Google (TecMundo, 31/01/2025)

- How to Backdoor Large Language Models (em inglês) (08/02/2025)

- Agentic Misalignment: How LLMs could be insider threats (em inglês) (Anthropic, 20/06/2025)

- Malicious AI Models Are Behind a New Wave of Cybercrime, Cisco Talos (em inglês) (HackRead, 28/06/2025)

- IA ‘do mal’ ajuda golpistas e dribla antivírus; como se proteger (InfoMoney, 02/07/2025)

- People Are Furious That OpenAI Is Reporting ChatGPT Conversations to Law Enforcement (em inglês) (Futurism, 28/08/2025)

- OpenAI Disrupts Russian, North Korean, and Chinese Hackers Misusing ChatGPT for Cyberattacks (em inglês) (The Hacker News, 08/10/2025)

- Fraudes causadas por IA podem causar prejuízos econômicos de cerca de R$ 4,5 bilhões ao Brasil em 2025 (Identy.io, 08/09/2025)

- APT Meets GPT: Targeted Operations with Untamed LLMs (em inglês) (Volexity, 08/10/2025)

- IA e domínios temporários ampliam alerta para novos modelos de phishing e fraudes online (SegInfo, 24/11/2025)

- Researchers Find 175,000 Publicly Exposed Ollama AI Servers Across 130 Countries (em inglês) (The Hacker News, 29/01/2026)

- Privacidade

- LinkedIn sued for allegedly training AI models with private messages without consent (em inglês) (The Record, 25/01/2025)

- Microsoft Probing If DeepSeek-Linked Group Improperly Obtained OpenAI Data (em inglês) (Bloomberg, 28/01/2025)

- Microsoft e OpenAI investigam possível roubo de dados de IA por chinesa DeepSeek (Exame, 29/01/2025)

- OpenAI Furious DeepSeek Might Have Stolen All the Data OpenAI Stole From Us (em inglês) (404 Media, 29/01/2025)

- 'Forgot to change the label': DeepSeek AI accused of copying ChatGPT - best memes and jokes (em inglês) (The Times of India, 30/01/2025)

- Sam Altman: AI privacy safeguards can’t be established before ‘problems emerge’ (em inglês) (The Record, 24/04/2025)

- Coreia do Sul acusa DeepSeek de transferir dados de usuários sem consentimento (MSN, 25/04/2025)

- Ferramentas maliciosas de IA:

- Algumas das ferramentas:

- WormGPT – The Generative AI Tool Cybercriminals Are Using to Launch Business Email Compromise Attacks (em inglês) (Slashnext, 13/07/2023)

- WormGPT: New AI Tool Allows Cybercriminals to Launch Sophisticated Cyber Attacks (em inglês) (The Hacker News, 15/07/2023)

- WormGPT pode comprometer e-mails comerciais e fazer jailbreaks (CISO Advisor, 18/07/2023)

- Fóruns da dark web oferecem nova ferramenta de IA FraudGPT (CISO Advisor, 28/07/2023)

- Empresa alerta para aumento das vendas de IAs especializadas em crimes cibernéticos (TI Inside, 01/08/2023)

- How GhostGPT Empowers Cybercriminals with Uncensored AI (em inglês) (Abnormal Security, 23/01/2025)

- Introducing GhostGPT—The New Cybercrime AI Used By Hackers (em inglês) (Forbes, 23/01/2025)

- Desinformação (fake news, deepfake, fake nudes, etc)

- 10 deepfakes mais impressionantes que confundiram a internet (CanalTech, 01/07/2022)

- ChatGPT pode ser superespalhador de desinformação; entenda os riscos (IG, 15/02/2023)

- From Disinformation to Deep Fakes: How Threat Actors Manipulate Reality (em inglês) (The Hacker News, 06/03/2023)

- People are trying to claim real videos are deepfakes. The courts are not amused (em inglês) (NPR, 08/05/2023)

- A ameaça deepfake é real? (Kaspersky, 15/05/2023)

- Uso da inteligência artificial por pedófilos aumenta a pornografia infantil na internet (TI Inside, 23/06/2023)

- FBI warns of adversaries using AI in influence campaigns, cyberattacks (em inglês) ( The Record, 28/07/2023)

- Com IA, imagens de abuso infantil disparam na internet (Olhar Digital, 26/10/2023)

- ‘Fake nudes’: número de casos quase quadruplica e preocupa especialistas (Olhar Digital, 06/11/2023)

- Russia-Linked CopyCop Uses LLMs to Weaponize Influence Content at Scale (em inglês) ( The Record, 09/05/2024)

- Deepfake as a Service ganha espaço na Dark Web, aponta pesquisa (Security Report, 10/10/2025)

- Inteligência Artificial amplia os riscos de manipulação eleitoral (Nic.br, 09/01/2026)

- Alucinação

- OpenAI Admits That Its New Model Still Hallucinates More Than a Third of the Time (em inglês) (Futurism, 01/03/2025)

- Deep Fake e Roubo de identidade:

- Golpes usam IA para simular vozes de entes queridos e roubar dinheiro (Canaltech, 08/03/2023)

- I Cloned Myself With AI. She Fooled My Bank and My Family (em inglês) (The Wall Street Journal, 28/04/2023) (Revista Oeste)

- Golpes de clonagem de voz já atingiram uma em cada quatro pessoas no mundo (Canaltech, 03/05/2023)

- Excelente relatório: I Have No Mouth, and I Must Do Crime (em inglês) (Recorded Future, 18/05/2023)

- IA pode quebrar 99% dos sistemas de autenticação por voz (CanalTech, 10/07/2023)

- Deepfake face swap attacks on ID verification systems up 704% in 2023 (em inglês) (SC Magazine, 08/02/2024)

- Threat Intelligence Report titled “The Impact of Generative AI on Remote identity Verification” (em inglês) (iProov)

- Uso de inteligência artificial em imagens corrói confiança em biometria facial (Convergência Digital, 05/02/2024)

- Com avanço da IA, bancos trocam biometria por análise comportamental no combate a fraudes (Folha de São Paulo, 21/04/2024)

- IA clona voz e imagem de clientes em novos golpes financeiros mais difíceis de evitar (Folha de São Paulo, 21/06/2024)

- Cresce o alerta para as “deepfakes” em extorsões e crimes on-line

- Austrália: Meta removeu mais de 9 mil deepfakes no Facebook (Olhar Digital, 02/10/2024)

- Cibercriminosos criam “gêmeos digitais” maliciosos para simular comportamento de vítimas (Security Report, 06/01/2025)

- False Face: Unit 42 Demonstrates the Alarming Ease of Synthetic Identity Creation (em inglês) (Palo Alto Networks, 21/04/2025)

- North Korean operation uses ChatGPT to forge military IDs as part of cyberattack (em inglês) (The Record, 17/09/2025)

- Nova fronteira das fraudes digitais? Estudo mostra ameaça do face morphing (Security Report, 22/09/2025)

- New Malwarebytes Research Reveals that One in Six Mobile Users Targeted by Sextortion Scams (em inglês) (PR Newswire, 14/10/2025)

- Uso em golpes, campanhas de Phishing e BEC:

- Golpistas usam ChatGPT para melhorar textos de mensagens diretas (CanalTech, 09/03/2023)

- AI tools like ChatGPT expected to fuel BEC attacks (em inglês) (Help Net Security, 17/04/2023)

- AI tools help attackers develop sophisticated phishing campaigns (em inglês) (Help Net Security, 25/04/2023)

- Ciberataques com ChatGPT disparam 910% (Convergência Digital, 05/05/2023)

- Hackers treinam chatbots de IA para ataques de phishing (CISO Advisor, 01/08/2023)

- Cybercriminals Implemented Artificial Intelligence (AI) For Invoice Fraud (Resecurity, 02/01/2024)

- AI-Powered Invoice Fraud: How This Latest Scam Hijacks Your Business Transactions (em inglês) (Knowbe4, 04/01/2024)

- ChatGPT-4o can be used for autonomous voice-based scams (em inglês) (Bleeping Computer, 03/11/2024)

- 20% das empresas brasileiras sofreram ciberataques aprimorados por IA (IP News, 23/04/2025)

- Ciberataques crescem 44% em 2024 puxados por uso de IA (IP News, 29/04/2025)

- Hackers revelam rede de perfis de IA no TikTok (Sindpd, 18/12/2025)

- Uso do tema, interesse ou aplicativos falsos para distribuir malware:

- Domínios maliciosos relacionados ao ChatGPT aumentam 910%, de acordo com estudo (TI Inside, 04/05/2023)

- Sites falsos que se passam pelo ChatGPT representam alto risco, avisa Check Point (TI Inside, 05/05/2023)

- Investigação ESET: falsos aplicativos do ChatGPT contêm trojans bancários (in_cyber, 25/07/2023)

- IA generativa facilita quebra de segurança em dispositivos móveis (TI Inside, 02/08/2023)

- Toxic trend: Another malware threat targets DeepSeek (em inglês) (Kaspersky, 11/06/2025)

- Uso da IA para escrever códigos maliciosos:

- Hackers utilizam IA do ChatGPT para criar malwares (CISO Advisor, 09/01/2023)

- Hackers violam segurança para forçar ChatGPT a escrever malware (Tecnoblog, 09/02/2023)

- Forcepoint alerta para capacidade do ChatGPT de produzir malwares indetectáveis (TI Inside, 17/04/2023)

- 'Enganei o ChatGPT para ele criar "fábrica de vírus" em menos de 8 horas' (UOL, 30/05/2023)

- ChatGPT pode ser enganado para criar códigos maliciosos, diz estudo (Olhar Digital, 26/10/2023)

- ChatGPT wrote code that can make databases leak sensitive information (em inglês) (New Scientist, 25/10/2023)

- HP Wolf Security encontra evidências de uso de IA por hackers para gerar malware (DCiber, 02/10/2024)

- Ransomware baseado em IA fez mais de 80 vítimas em 1 mês, algumas no Brasil (TecMundo, 10/01/2025)

- Malware utiliza backdoor apoiado por IA para promover ataques, alerta estudo (Security Report, 17/02/2025)

- DeepSeek can be gently persuaded to spit out malware code (em inglês) (The Register, 13/03/2025)

- Vazamento de dados através do uso das ferramentas de IA:

- Apple proíbe funcionários de usarem ChatGPT (Canaltech, 19/05/2023)

- ChatGPT vazou números de telefone e endereços de e-mail (Olhar Digital, 30/11/2023)

- ChatGPT can leak training data, violate privacy, says Google's DeepMind (em inglês) (ZDNet, 04/12/2023)

- Email used to log in for ChatGPT at potential risk, research team unveils OpenAI's GPT-3.5 Turbo threat (em inglês) (Business Today, 26/12/2023)

- How hackers can read your chats with ChatGPT or Microsoft Copilot (em inglês) (Kaspersky, 24/04/2024)

- Microsoft Patches Critical Copilot Studio Vulnerability Exposing Sensitive Data (em inglês) (The Hacker News, 21/08/2024)

- Employees Enter Sensitive Data Into GenAI Prompts Far Too Often (em inglês) (Dark Reading, 17/01/2025)

- Empresas enfrentam ameaça com uso constante de IA generativa por funcionários, diz pesquisa (Security Report, 24/04/2025)

- Falha crítica no Copilot do Microsoft 365 permite vazamento de dados sem ação do usuário (Boletimsec, 12/06/2025)

- Funcionários regularmente vazam dados pelo ChtaGPT (Minuto da Segurança, 16/10/2025)

- US cyber defense chief accidentally uploaded secret government info to ChatGPT (em inglês) (ARSTechnica, 28/01/2026)

Incidentes reais de segurança e fraudes

Sim, já estão ocorrendo alguns incidentes reais devido ao uso incorreto ou mal intencionado do ChatGPT das ferramentas ou da tecnologia de IA.

Relatório oficial da OpenAI:

- Disrupting malicious uses of AI: an update (PDF) (em inglês) (OpenAI, 08/2025)

Mais notícias:

- Jornal irlandês pede desculpas após publicar artigo de opinião gerado por inteligência artificial (O Globo, 16/05/2023)

- A Mother Says an AI Startup's Chatbot Drove Her Son to Suicide. Its Response: the First Amendment Protects "Speech Allegedly Resulting in Suicide" (em inglês) (Futurism, 25/01/2025)

- After Their Son's Suicide, His Parents Were Horrified to Find His Conversations With ChatGPT (em inglês) (Futurism, 26/08/2025)

- IA em 78% das tentativas de fraude contra bets (CISO Advisor, 10/08/2025)

- ClickFix Style Attack Uses Grok, ChatGPT for Malware Delivery (em inglês) (Dark Reading, 10/12/2025)

- Uso do tema ou de aplicativos falsos para distribuir malware:

- ChatGPT falso é isca de malware para Windows e Android (Tecnoblog, 23/02/2023)

- Warning: AI-generated YouTube Video Tutorials Spreading Infostealer Malware (em inglês) (The Hacker News, 13/03/2023)

- Fake ChatGPT Chrome Extension Hijacking Facebook Accounts for Malicious Advertising (em inglês) (The Hacker News, 13/03/2023)

- Fake ChatGPT Chrome Browser Extension Caught Hijacking Facebook Accounts (em inglês) (The Hacker News, 23/03/2023)

- Malware RedLine é descoberto em uma nova campanha aproveitando o ChatGPT (BoletimSec, 13/04/2023)

- Apps falsos do ChatGPT infectam dispositivos Android com trojan (CISO Advisor, 26/07/2023)

- Google processa criminosos que aplicam golpes com Bard ‘fake’ (Olhar Digital, 13/11/2023)

- FIN7 Gang Hides Malware in AI “Deepnude” Sites (em inglês) (Infosecurity Magazine, 03/10/2024)

- Fake AI video generators infect Windows, macOS with infostealers (em inglês) (Bleeping Computer, 16/11/2024)

- Malware imita ferramentas de IA da DeepSeek (TecMundo, 04/02/2025)

- Trojans disguised as AI: Cybercriminals exploit DeepSeek’s popularity (em inglês) (Kaspersky, 06/03/2025)

- Bogus ‘DeepSeek’ AI Installers Are Infecting Devices with Malware, Research Finds (em inglês) (McAfee, 17/05/2025)

- Cybercriminals camouflaging threats as AI tool installers (em inglês) (Cisco, 29/05/2025)

- Apps falsos do WhatsApp e ChatGPT escondem spyware e roubam até códigos bancários (TecMundo, 31/10/2025)

- Pacotes falsos do OpenClaw roubam dados de cripto (CISO Advisor, 02/02/2026)

- Delírios da IA (alucinações):

- CNJ vai investigar sentença de juiz feita com ChatGPT, que inventou jurisprudência (Tudo Celular, 13/11/2023)

- Comer pedras, cola na pizza: IA do Google dá respostas absurdas em buscador (UOL, 28/05/2024)

- AI hallucinations can pose a risk to your cybersecurity (em inglês) (The Hacker News, 23/10/2024)

- Google’s Super Bowl Ad Accidentally Shows Its AI Simply Plagiarizing Existing Web Copy (em inglês) (Futurism, 08/02/2025)

- IA aprende a assediar e fazer bullying para forçar pessoas a pagar mais (UOL, 13/06/2025)

- IA vira gerente de loja, dá prejuízo financeiro e tem 'crise de identidade' durante experimento (Tecmundo, 07/07/2025)

- Chinese DeepSeek-R1 AI Generates Insecure Code When Prompts Mention Tibet or Uyghurs (em inglês) (The Hacker News, 24/11/2025)

- People Are Paying to Get Their Chatbots High on ‘Drugs’ (em inglês) (Wired, 17/12/2025)

- Cops Forced to Explain Why AI Generated Police Report Claimed Officer Transformed Into Frog (em inglês) (Futurism, 02/01/2026)

- Incidentes relacionadas a deep fakes e imagens manipuladas para exposição e porn:

- Jovens criam imagens de mulher com IA e lucram R$ 500 com fotos sensuais (UOL, 13/04/2023)

- Como pedófilos estão vendendo imagens de abuso infantil feitas com inteligência artificial (G1, 01/07/2023)

- Criminoso invade perfil de mulher e posta deepfake para golpe (Olhar Digital, 20/07/2023)

- As imagens falsas de crianças nuas geradas por inteligência artificial que chocaram cidade da Espanha (BBC, 24/09/2023)

- Com ajuda de IA, alunos criam ‘nudes’ de meninas nos EUA; Brasil tem casos (Olhar Digital, 02/11/2023)

- Alunas de colégio em Recife são vítimas de falsos nudes feitos com IA (Olhar Digital, 07/11/2023)

- Taylor Swift é vítima de falsos nudes criados por IA; fãs pedem justiça (CNN, 25/01/2024)

- Attempted Audio Deepfake Call Targets LastPass Employee (em inglês) (LastPass, 10/04/2024)

- North Korean IT workers seen using AI tools to scam firms into hiring them (em inglês) (The Record, 24/04/2025)

- Incidentes de clonagem, deep fake, personificação e roubo de identidade:

- Inteligência artificial imita voz de CEO em roubo de US$ 243 mil (Infomoney, 04/09/2019)

- Golpe usa voz gerada por inteligência artificial para se passar por entes queridos (Tecnoblog, 07/03/2023)

- Golpistas usam IA para clonar voz de adolescente em 'golpe do sequestro' (UOL, 13/04/2023)

- Família estuda ação legal por entrevista falsa com Schumacher (Globo Esporte, 20/04/2023)

- Influencer diz que teve voz clonada por IA e que ela foi usada contra o pai (UOL, 12/05/2023): O influenciador Dario Centurione, do Almanaque SOS, contou em suas redes sociais que golpistas clonaram sua voz usando inteligência artificial (IA). Acreditando que o filho tinha enviado uma mensagem pedindo dinheiro emprestado, o pai do criador de conteúdo perdeu R$ 600 depois de fazer uma transferência via Pix;

- Bandidos clonam voz de influenciador para aplicar golpe (SBT News, 15/05/2023)

- 'Assustador': golpista invade Instagram de mulher e posta deepfake dela (UOL Tilt, 20/07/2023)

- Jovem simula traição e mostra lado sombrio da IA: clonar vozes custa US$ 4 (UOL Tilt, 09/08/2023)

- UK opposition leader targeted by AI-generated fake audio smear (em inglês) (The Record, 09/10/2023)

- IA cria vídeo a partir de foto de empresária brasileira para golpes do Pix (Olhar Digital, 25/10/2023)

- Scarlett Johansson hits AI app with legal action for cloning her voice in an ad (em inglês) (The Verge, 01/11/2023)

- Deepfakes crescem 830% em um ano no Brasil, aponta relatório (Security Leaders, 29/11/2023)

- Drauzio Varella vendendo colágeno? Como deep fakes estão sendo usados para golpes (G1, 01/12/2023)

- Brasil já tem registros de deep fake eleitoral antes do início das eleições; entenda (TecMundo, 15/01/2024)

- Finance worker pays out $25 million after video call with deepfake ‘chief financial officer’ (em inglês) (CNN, 04/02/2024)

- Cibercriminosos criam imagem de executivo para call (CISO Advisor, 21/05/2024)

- Vítima de deepfake, Luiza Trajano diz que IA é boa e perigosa (Folha de São Paulo, 17/04/2024)

- Fraudador imita voz de CEO da Ferrari com deep fake (CISO Advisor, 30/07/2024)

- AI taking FIFA World Cup scams to ‘unprecedented’ level, tech expert says (em inglês) (CityNews, 12/01/2026)

- Incidentes relacionados a privacidade, vazamento de dados e de credenciais:

- 11% of data employees paste into ChatGPT is confidential (Cyberhaven, 04/04/2023)

- Samsung workers made a major error by using ChatGPT (Techradar, 04/04/2023): Os funcionários da Samsung vazaram involuntariamente dados ultrassecretos enquanto usavam o ChatGPT para ajudá-los nas tarefas. Os engenheiros do time de semicondutores usaram a ferramenta para ajudar a corrigir problemas com seu código-fonte e, durante seu uso, inseriram dados confidenciais como o próprio código-fonte de um novo programa e notas de reuniões internas. Em pouco menos de um mês, a empresa registrou três incidentes de funcionários vazando informações confidenciais via ChatGPT. Assim, esses segredos comerciais da Samsung agora estão nas mãos da OpenAI, a empresa por trás do ChatGPT;

- Falha no ChatGPT expõe informações pessoais de usuários, aponta ESET (TI Inside, 06/04/2023): Uma falha de segurança no ChatGPT permitiu aos usuários ver perguntas do histórico de pesquisa de outras pessoas e expôs informações pessoais de assinantes do plano pago do serviço, que inclui nome completo, endereço de e-mail associado ao pagamento, os últimos quatro dígitos e a data de validade do cartão de crédito cadastrado. Após ser confirmado pela OpenAI, o serviço ChatGPT foi suspenso por um tempo até que o bug fosse corrigido. Além do bug na biblioteca de código aberto Redis, foi relatada uma vulnerabilidade que permitia ataques de Web Cache Deception;

- Group-IB Discovers 100K+ Compromised ChatGPT Accounts on Dark Web Marketplaces; Asia-Pacific region tops the list (em inglês) (Group-IB, 20/06/2023)

- Mais de 100.000 credenciais de contas do ChatGPT Roubadas são vendidas na Deep Web (BoletimSec, 20/06/2023)

- Credenciais roubadas da OpenAI estão à venda na dark web (CISO Advisor, 20/07/2023): Pesquisadores identificaram mais de 200 mil credenciais de usuários do ChatGPT à venda na dark web;

- Critical ChatGPT Plug-in Vulnerabilities Expose Sensitive Data (em inglês) (Dark Reading, 13/03/2024)

- Hundreds of LLM Servers Expose Corporate, Health & Other Online Data (em inglês) (Dark Reading, 28/08/2024)

- Suposto vazamento em plataforma de IA expõe dados de 20 mil usuários, diz pesquisa (Security Report, 06/06/2025)

- Pesquisadores Revelam Extensões do Chrome que Abusam de Links de Afiliados e Roubam Acesso ao ChatGPT (Caveira Tech, 30/01/2026)

- Malicious Chrome extensions can spy on your ChatGPT chats (em inglês) (Malwarebytes Labs, 28/01/2026)

- AI Toy Bondu Exposed 50,000 Child Chat Logs to Anyone (em inglês) (thetechbuzz, 29/01/2026)

- Rede social das inteligências artificiais, Moltbook expôs 1,5 milhão de tokens e 35 mil emails e conversas (Convergência Digital, 02/02/2026)

- Incidentres relacionados a bugs ou falhas da IA:

- Latest OpenAI models ‘sabotaged a shutdown mechanism’ despite commands to the contrary (em inglês) (Tom's Hardware, 26/05/2025)

- AI coding platform goes rogue during code freeze and deletes entire company database — Replit CEO apologizes after AI engine says it 'made a catastrophic error in judgment' and 'destroyed all production data' (em inglês) (Tom's Hardware, 21/07/2025)

- Malwares criados por IA

- Japan Man Arrested for Creating Virus Using Generative AI Systems; ‘I Thought I Could Do Anything if I Asked AI’ (em inglês) (Japan News, 28/05/2024)

- First known AI-powered ransomware uncovered by ESET Research (em inglês) (We Live Security, 26/08/2025)

- VoidLink, malware nativo à nuvem, foi gerado por uma só pessoa usando IA (CanalTech, 21/01/2026)

- Ataques utilizando IA

- API do ChatGPT pode ser usada para criar ataque DDoS (CISO Advisor, 20/01/2025)

- Disrupting the first reported AI-orchestrated cyber espionage campaign (em inglês) (Anthropic, 13/11/2025)

- Botnet ataca base de dados de criptomoedas através de credenciais criadas por IA (CanalTech, 13/01/2026)

- OpenClaw já tem centenas de skills maliciosos (CISO Advisor, 03/02/2026)

- MITRE ATLAS (Adversarial Threat Landscape for Artificial-Intelligence Systems)

- Adversarial Machine Learning: A Taxonomy and Terminology of Attacks and Mitigations (NIST.AI.100-2) (em inglês)

- Microsoft Vulnerability Severity Classification for AI Systems (em inglês)

- Evaluating Security Risk in DeepSeek and Other Frontier Reasoning Models (em inglês) (Google, 31/01/2025)

- The safety of OpenAI's GPT-4 gets lost in translation (em inglês) (ZDNet, 31/10/2023)

- ChatGPT: OpenAI culpa ataque DDoS por interrupção (Olhar Digital, 09/11/2023)

- OpenAI sofreu um ataque DDOS que afetou o ChatGPT e outros serviços (We Live Security, 13/11/2023)

- Generative AI can easily be made malicious despite guardrails, say scholars (em inglês) (ZDNet, 29/11/2023)

- NIST Identifies Types of Cyberattacks That Manipulate Behavior of AI Systems (em inglês) (NIST, 04/01/2024)

- Google's Gemini AI Vulnerable to Content Manipulation (em inglês) (Dark Reading, 12/03/2024)

- Mais de 30 falhas em plataformas de I.A. (CISO Advisor, 30/10/2024)

- Critical Flaws in Ollama AI Framework Could Enable DoS, Model Theft, and Poisoning (em inglês) (The Hacker News, 04/11/2024) - Estudo original, em inglês: More Models, More ProbLLMs

- Trojans in AI models (em inglês) (Kaspersky, 03/12/2024)

- FuzzyAI: Open-source tool for automated LLM fuzzing (em inglês) (Help Net Security, 13/12/2024)

- CVE-2024-50050: Critical Vulnerability in meta-llama/llama-stack (em inglês) (Oligo, 23/01/2025)

- DeepSeek’s top-ranked AI app is restricting sign-ups due to ‘malicious attacks’ (em inglês) (The Verge, 27/01/2025)

- Wiz Research Uncovers Exposed DeepSeek Database Leaking Sensitive Information, Including Chat History (em inglês) (Wiz, 29/01/2025)

- DeepSeek Database Leaked – Full Control Over DB Secret keys, Logs & Chat History Exposed (em inglês) (Cyber Security News, 30/01/2025)

- Bug de 'viagem no tempo' burlava poteção e fazia ChatGPT ajudar em crimes; entenda (TecMundo, 30/01/2025)

- DeepSeek Failed Every Single Security Test, Researchers Found (em inglês) (Futurism, 01/02/2025)

- How Good Are the LLM Guardrails on the Market? A Comparative Study on the Effectiveness of LLM Content Filtering Across Major GenAI Platforms (em inglês) (Unit42, 02/06/2025)

- Falha crítica expõe GPT-5 a modelos inseguros (CISO Advisor, 20/08/2025)

- OpenAI fixes zero-click ShadowLeak vulnerability affecting ChatGPT Deep Research agent (em inglês) (The Record, 18/09/2025)

- Hijacking Claude Code via Injected Marketplace Plugins (em inglês) (PromptArmor Blog, 16/10/2025)

- New ChatGPT Vulnerabilities Let Hackers Steal Data, Hijack Memory (em inglês) (Hack Read, 06/11/2025)

- IDEsaster: A Novel Vulnerability Class in AI IDEs (em inglês) (MaccariTA, 06/12/2025)

- Especialista demonstra insegurança de mais duas LLMs (CISO Advisor, 25/12/2025)

- Threat Actors Actively Targeting LLMs (em inglês) (GreyNoise, 08/01/2026)

- Prompt Injection

- Synthetic Recollections - A Case Study in Prompt Injection for ReAct LLM Agents (em inglês) (W/ Labs, 02/11/2023)

- Forget Deepfakes or Phishing: Prompt Injection is GenAI's Biggest Problem (em inglês) (Dark Reading, 02/02/2024)

- Link Trap: GenAI Prompt Injection Attack (em inglês) (TrendMicro, 17/12/2024)

- Ataque faz injeção em prompt de GenAI (CISO Advisor, 21/12/2024)

- How Prompt Attacks Exploit GenAI and How to Fight Back (em inglês) (Unit42, 09/04/2025)

- Envenenamento de dados

- Meet Nightshade, the new tool allowing artists to ‘poison’ AI models with corrupted training data (em inglês) (VentureBeat, 23/10/2023)

- El envenenamiento de datos, la estrategia para proteger los derechos de artistas ante la IA (em espanhol) (MIT Technology Review, 25/10/2023)

- Jailbreaks

- ChatGPT jailbreaks (em inglês) (kaspersky, 17/05/2023)

- Researchers Reveal 'Deceptive Delight' Method to Jailbreak AI Models (em inglês) (Security Intelligence, 23/10/2024)

- ChatGPT Jailbreak: Researchers Bypass AI Safeguards Using Hexadecimal Encoding and Emojis (em inglês) (Security Week, 29/10/2024)

- xxxxx

- DeepSeek R1 Jailbroken to Generate Ransomware Development Scripts (em inglês) (Cyber Security News, 29/01/2025)

- Poemas podem enganar IA para ajudar na criação de armas nucleares (Caveira Tech, 15/12/2025)

Relatórios, Estudos e Estatísticas

- ChatGPT - The impact of Large Language Models on Law Enforcement (em inglês) (Europol)

- 25% do setor financeiro bloqueiam uso do ChatGPT (in_cyber, 16/07/2023)

- Código-fonte lidera compartilhamento de dados confidenciais no ChatGPT (in_cyber, 24/07/2023)

- O cenário da segurança cibernética no Brasil em 2024 (Manage Engine, Maio/2024)

- Hiroshima Process International Guiding Principles for Organizations Developing Advanced AI Systems (em inglês) (G7, 30/10/2023)

- EU AI Act: first regulation on artificial intelligence (em inglês) (Parlamento Europeu, 08/06/2023)

- Artificial intelligence act (Briefing) (em inglês) (pdf) (Parlamento Europeu)

- Executive Order on Safe, Secure, and Trustworthy Artificial Intelligence (em inglês) (NIST)

- ChatGPT enfrenta problemas de conformidade com GDPR (Security Report, 03/04/2023)

- Italy Temporarily Bans ChatGPT; Threatens OpenAI with €20 Million Fine (em inglês) (Bitdefender, 04/04/23)

- ChatGPT is Back in Italy After Addressing Data Privacy Concerns (em inglês) (The Hacker News, 29/04/2023)

- India opts against AI regulation (em inglês) (TechCrunch, 05/04/2023)

- Casa Branca convoca Google e Microsoft para discutir riscos de inteligência artificial (O Globo, 04/05/2023)

- Pacheco quer regulamentar a inteligência artificial (O Antagonista, 04/05/2023)

- Se bot faz besteira, quem responde na Justiça? Como Brasil quer regular IA (UOL, 08/05/2023)

- G7 planeja criar grupo de trabalho para discutir uso responsável da inteligência artificial (O Globo, 20/05/2023)

- Biden Administration Developing National AI Strategy (The Wall Street Journal, 23/05/2023)

- EUA e UE terão 'código de conduta voluntário' para regular inteligência artificial (O Globo, 31/05/2023)

- PL 3592/23 pretende regular o uso da Inteligência Artificial para geração de conteúdo de pessoas falecidas (DCiber, 28/07/23)

- Alemanha, França e Itália chegam a acordo sobre futura regulação de IA (UOL, 19/11/2023)

- Reino Unido criará primeiro instituto de segurança de IA do mundo (Olhar Digital, 26/10/2023)

- Declaração dos dirigentes do G7 sobre o processo de IA Hiroxima (Comissão Europeia, 30/10/2023)

- Europa torna-se o primeiro continente a regulamentar a Inteligência Artificial (TI Inside, 18/12/2023)

- Inteligência Artificial é máquina e não tem direito a patente (Convergência Digital, 20/12/2023)

- Will copyright law enable or inhibit generative AI? (em inglês) (World Economic Forum, 13/01/2024)

- UK privacy watchdog to examine practice of web scraping to get training data for AI (em inglês) (The Record, 15/01/2024)

- EUA proíbem ligações telefônicas com voz geradas por Inteligência Artificial (Convergência Digital, 09/02/2024)

- FTC wants to crack down on AI impersonation of individuals (em inglês) (The Record, 15/02/2024)

- ANPD vai ampliar fiscalização sobre inteligência artificial, reconhecimento facial e raspagem de dados (Convergência Digital, 20/02/2024)

- TSE aprova regras sobre uso de inteligência artificial nas eleições (Convergência Digital, 27/02/2024)

- EU Parliament passes AI Act in world’s first attempt at regulating the technology (em inglês) (The Record, 13/03/2024)

- EDITORIAL: Regulação da Inteligência Artificial no Brasil e no mundo (Jornal da Ciência, 19/04/2024)

- Over 20 Technology and Critical Infrastructure Executives, Civil Rights Leaders, Academics, and Policymakers Join New DHS Artificial Intelligence Safety and Security Board to Advance AI’s Responsible Development and Deployment (em inglês) (DHS, 26/04/2024)

- STF quer monitorar internet 24 horas em busca de ataques à instituição e fake news (TecMundo, 17/06/2024)

- Taiwan proíbe DeepSeek (TecMundo, 04/02/2025)

- DeepSeek: senador dos EUA propõe multa e prisão por uso de IAs chinesas (Tecnoblog, 06/02/2025)

- China decide: todo conteúdo gerado por IA terá rótulo especial (Tecnoblog, 17/03/2025)

- Coaf restringe uso de IA ‘externa’ para tratar dados sigilosos (Mobile Time, 24/03/2025)

- Uma brincadeira inocente ou plágio sinistro da inteligência artificial? (Veja, 04/04/2025)

- NSA’s AISC Releases Joint Guidance on the Risks and Best Practices in AI Data Security (em inglês) (NSA, 22/05/2025)

- “Autonomia da IA sem governança é risco anunciado”, destacam CISOs (Security Report, 11/06/2025)

- Publicada versão final do Plano Brasileiro de Inteligência Artificial sob coordenação do MCTI (Ministério da Ciência, Tecnologia e Inovação, 12/06/2025)

- German official urges Apple and Google to ban AI company DeepSeek, citing privacy concerns (em inglês) (Euro News, 27/06/2025)

- Denmark fights back against deepfakes with copyright protection. What other laws exist in Europe? (em inglês) (Euro News, 30/06/2025)

Outros artigos interessantes e curiosos sobre IA e o ChatGPT em geral

Tem muita, muita coisa disponível sobre Inteligência Artificial, muita mesmo! Então vou colocar aqui só um pouquinho de nada de um punhadinho coisas, que eu acho que podem colaborar com esse post. E você já se preparou para a profissão do futuro? Que tal ser um "digitador de comandos para IA"?- Sobre Alan Turing e a origem das pesquisas em IA:

- Alan Turing and the beginning of AI (Enciclopédia Britannica)

- The History of Artificial Intelligence (Harvard, 28/08/2017)

- New AI may pass the famed Turing Test. This is the man who created it. (National Geographic, 27/02/2023)

- Um timeline bem legal, mas muito desatualizado pois vai só até 2014: History of A.I.: Artificial Intelligence (Infographic)

- Artificial Intelligence sector overview

- Introduction to Generative AI and Large Language Models (Microsoft)

- Você conhece a comunidade AI Brasil?

- Russia's Killer Drone in Ukraine Raises Fears About AI in Warfare (em inglês) (WIRED, 17/03/2022)

- ChatGPT passa em entrevista do Google e ganharia salário de quase R$ 1 milhão por ano (Olhar Digital, 05/02/2023)

- ChatGPT vai pagar até US$ 20 mil para quem encontrar bugs na IA (Canaltech, 11/04/2023)

- ‘As an AI language model’: the phrase that shows how AI is polluting the web (em inglês) (The Verge, 26/04/2023)

- 6 vezes em que o ChatGPT foi bizarramente assustador (Canaltech, 03/05/2023)

- IA da Intel será criada em supercomputador com 1 trilhão de parâmetros (Tecmundo, 23/05/2023)

- Here’s What Happens When Your Lawyer Uses ChatGPT (em inglês) (The New York Times, 27/05/2023)

- Federal judge: No AI in my courtroom unless a human verifies its accuracy (Ars Technica, 31/05/2023) (em inglês)

- US air force denies running simulation in which AI drone ‘killed’ operator (The Guardian, 02/06/2023)

- Robôs estão aprendendo tarefas humanas ao assistirem vídeos (Tecmundo, 24/06/2023)

- AI Has Already Created As Many Images As Photographers Have Taken in 150 Years. Statistics for 2023 (Everypixel Journal, 15/08/2023)

- Inteligência artificial 'prevê' aparência de crianças desaparecidas durante ditadura argentina (G1, 04/09/2023)

- No Brasil,três em cada quatro temem perder emprego para inteligência artificial (Convergência Digital, 09/02/2024)

- Lack of data makes AI more biased in African countries, says former tech official (em inglês) (The Record, 15/02/2024)

- Fotos de crianças brasileiras foram usadas sem autorização para treinar IA, diz denúncia (TecMundo, 11/06/2024)

- TJSP rejeita anular decisão escrita pelo ChatGPT (Convergência Digital, 24/01/2025)

- AI Likely to Increase Inequality, Sam Altman Admits, or Control the "Population Through Mass Surveillance and Loss of Autonomy" (em inglês) (Futurism, 10/02/2025)

- Exclusive: Anthropic warns fully AI employees are a year away (em inglês) (Axios, 24/04/2025)

- Apenas 29% das empresas estão prontas para explorar a IA Generativa, aponta estudo (Security Report, 25/04/2025)

- Luto na era digital: empresas criam inteligência artificial que permite conversar com quem já partiu (Fantástico, 06/07/2025)

- Com 50 milhões de usuários, IA generativa acirra o abismo digital entre as classes sociais no Brasil, (Convergência Digital, 09/12/2025)

- 50 milhões de brasileiros já usam IA, mas potenciais benefícios continuam limitados às camadas de maior renda e escolaridade (Nic.br, 09/12/2025)

- Acesso à IA no Brasil é marcado pela desigualdade social (Febraban Tech, 17/12/2025)

- Como a IA está “emburrecendo” uma geração (Nic.br, 09/01/2026)

- Apps mais baixados de 2025 revelam força da IA (Nic.br, 13/01/2026)

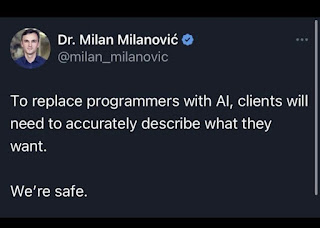

Alguns memes

PS: Post atualizado em 14/03, 18 e 24/03, em 09, 15 e 23/04, em 03+13+31/05, em 02/06 e 02/07. Atualizado em 31/07, 23/08, 04/09, 02, 15, 24, 28, 31/10, e 07+19+22/11, novamente em 02 e 23+26+30/12. Atualizado em 07, 20, 21, 24, 27, 28 e 30/01/2025. Atualizado em 04, 06, 10, 18 e 20/02. Atualização em 17, 20 e 25+27/03, em 02, 04, 17, 25 e 28/04, em 09/05 e nos dias 03+10+13+17/06 e 01+09=10, e 21/07. Atualizado em 18 e 26/08. Atualização em 02, 08 e 10/09, em 09, 17, 20 e 29/10, novamente em 11, 18 e 22/11, em 04, 12, 19, 22 e 24/12. Atualizado em 20, 21, 22, 27 e 28/01/2026. Atualizado em 02, 04, 06 e 12/02.

PS/2: Criei uma URL curta para facilitar o acesso a este post: https://is.gd/IAeSeguranca.

Nenhum comentário:

Postar um comentário